당신이 어렸을 때 상상하던 미래의 모습과 지금은 얼마나 비슷한가요? 하늘을 날아다니는 자동차나, 개인용 로켓을 타고 달나라를 여행하거나, 집에서 집안일을 도와주는 가정용 로봇 등을 상상해 본 적이 한 번쯤은 있을 겁니다. 그런 상상 중 일부는 이미 우리의 실생활에서 자연스럽게 실현되고 있거나 혹은 그런 상상을 현실화하는 단계에 이르고 있습니다. 오늘은 우리의 상상 중 ‘자동차’의 발전에 관해 이야기를 나눠보고자 합니다.

우리의 상상과는 다르게 아직 자동차는 하늘을 날아다니지는 않지만, 무수한 발전을 경험하고 있습니다. 내연 기관으로만 작동하던 이전과 달리, 전기, 수소 등 다양한 에너지원을 사용하게 되었고, 이전처럼 ‘사람’만이 운전할 수 있었던 시대를 넘어서 사람이 운전을 ‘보조’하는 정도의 형태로도 발전하게 되었습니다.

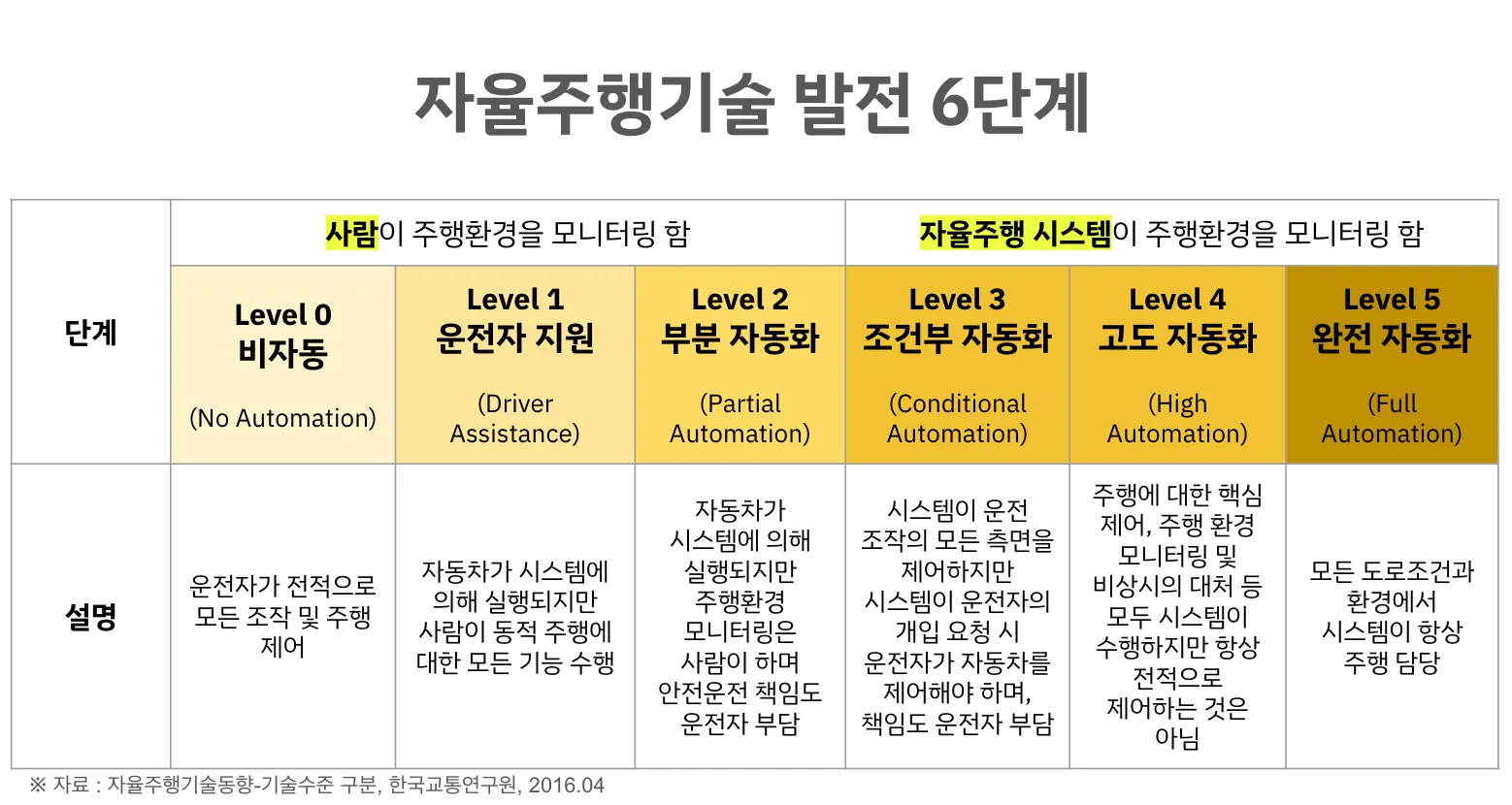

우리가 흔히 말하는 ‘자율주행 자동차’는 운전자 또는 승객의 조작 없이 자동차 스스로 운행이 가능한 자동차를 말합니다. 운전자의 조작 없이 스스로 운행이 가능하게끔 하는 자율주행기술은 차량 업계에서 미래 차 기술의 정점으로 볼 수 있습니다. 현재 자율주행기술은 기술 수준에 따라 총 6단계로 나누어집니다.

자율주행은 먼 미래처럼 느껴졌지만, 현재는 상용화가 되었으며, 사람들이 기꺼이 돈을 소비하는 서비스의 형태로 발전되었습니다. 가령 미국의 경우 이미 웨이모가 여러 도시에서 사람들을 태우고 도시 곳곳을 누비고 있으며, 테슬라의 Full Self-Driving (FSD) 또한 월 구독료를 지급하고 사용할 수 있게 제공되고 있습니다. 웨이모의 경우 현재 Level 4로 분류되며, 라이다·레이더·29개의 카메라를 조합해 다중 센서를 통해 자율주행하고 있습니다. 테슬라는 이와 다른 행보를 보이고 있는데요, 카메라와 AI 기술만으로 자율주행을 구현합니다.

자율주행 기술이 상용화되고 있음에도 불구하고 기술의 성능만으로는 사람들이 이 기술을 곧바로 신뢰하게 설득하기는 어렵습니다. Harvard Business School에서 Rachel Layne이 작성한 ‘Why people blame self-driving cars more than human drivers’라는 글에서 Julian De Freitas의 논문을 다음과 같이 인용합니다 — 자율주행차량의 경우 아직 익숙하지 않고 불안정한 기술로 인식되기 때문에 사람들은 이 기술의 확장과 더 보편적 적용에 관해 난색을 보입니다.

기술을 구현하는 방식에는 차이가 있지만 두 회사 모두 높은 수준의 기술력을 보유하고 있다는 사실은 자명합니다. 하지만 두 회사 중 그 어느 쪽도 해결하지 못한 blind spot이 있다면 믿으실까요? 바로 ‘소리’입니다. 생각해 보세요. 우리 또한 무언가 보이지 않아도, 소리를 듣는 순간 자연스럽게 반응하고 위험을 피하는 경우가 많습니다. 그건 인간에게 자연스러운 일이며, 자율주행차량도 인간과 동일하게 반응할 수 있습니다.

결국 real-world scaling을 해야 하는 상황에서 자율주행차량 업체들의 경쟁은 어떤 센서를, 얼마나 더 추가해야 하는지에 있지 않습니다. 어떤 modality가 더 빠르고 정확하게 위험을 감지해 사람들의 기술에 대한 불안감을 낮추고, 이 기술을 믿게끔 만들 수 있을까에 달렸습니다. 그리고 Cochl은 그 해답을 ‘Auditory modality’라고 제안합니다.

그렇다면 저희가 제안하는 auditory modality가 실제로 어떻게 적용될 수 있을까요?

1. 도로 노면 상태 감지

겨울철이면 심심치 않게 뉴스에 등장하는 단골 손님이 있습니다. 바로 눈길에 미끄러진 차 사고인데요, 흔히 ‘블랙 아이스’라고 불리는 이 노면 상태는 많은 운전자들이 겨울철에 주행하는 것을 두렵게 만듭니다.

문제는 카메라나 라이다만으로는 노면의 마찰력이나 질감 변화를 즉각적으로 정량화하기 어려울 수 있습니다. 그렇다면 Sound AI가 이 부분에서 어떤 도움을 줄 수 있을까요? 가령 정상적인 노면 상황에서 타이어가 도로에 마찰할 때 나는 소리와 눈·비·자갈·수막 등 다양한 기상 환경 상황에서 마찰하는 소리 등 상태를 분류할 수 있습니다. 이를 통해 자율주행 시 기상 악조건 상황에서 정지거리나 차선 유지에 있어 보수적으로 운행하여 안전성을 강화하거나, 혹은 사고 발생률의 가능성을 더 예민하게 봐 빠른 대응이 가능하게 만들어 자율주행 제어의 안전 마진을 확대할 수 있습니다.

IEEE Spectrum에서 Fraunhofer Institute의 연구팀이 발표한 주행 차량 센서에 청각 레이어를 더해 환경 음을 분석하고 자동차가 그들이 보지 못한 위험에 대응할 수 있도록 돕는 ‘hearing car’의 콘셉트가 auditory modality의 중요성에 가중치를 더해줍니다.

2. 엔진 및 차량 고장 감지

자율주행 이전 시대부터 우리는 운전하다 들리는 낯선 소리를 위험 신호라고 직감적으로 받아들여 왔습니다. 브레이크 패드가 닳았을 때 나는 끽끽거리는 소리, 혹은 엔진 내부 마찰이 증가했을 때 나는 거친 소리는 시각 센서로는 탐지하기가 매우 어렵고, 특히 운전자가 없는 상황에서는 파악하기 어렵습니다.

Sound AI는 정상 주행 시 나는 소리를 기반으로 비정상적인 음향 패턴을 파악해 문제 발생 전 단계에서 조기 경고를 보낼 수 있습니다. 단순한 고장 예측을 바탕으로 이는 제조사/서비스 사업자는 차량 운영 비용 절감, 정비 공정 단축, 선제적 유지 보수 가능성을 높일 수 있고, 탑승자로서도 운전자가 없는 환경에서도 높은 심리적 안정감을 느낄 수 있습니다.

3. 실내외 사운드 이벤트 감지

차량 운행 중 차량 내부에 사고가 발생하는 경우는 어떨까요? 웨이모의 경우 차량에 승하차하기 위해서는 앱에서 ‘문 열기’ 버튼을 눌러야만 작동하고, 비상시에는 ‘Pull over’라는 정차 버튼을 눌러 내릴 수 있습니다. 하지만 격한 충격이나 난동 등 사고가 발생할 때는 앱을 작동하거나 버튼을 누르기 쉽지 않습니다. 이런 상황에서 총격 음이나 비명 등의 소리가 탐지되면 자동으로 경고/비상 프로토콜을 실행하게 된다면 어떨까요? 그렇게 된다면 더 급한 상황에서 빠른 대응이 가능하지 않을까요?

또는 유리가 깨지거나, 파손 혹은 폭력적 상황에 대한 소리 징후가 감지된다면 바로 사고 대응팀과 연결이 된다든지 혹은 차량 내부의 카메라가 자동으로 상황 녹화를 하는 식으로 안전사고를 예방할 수 있습니다. 또한 자율주행 차량 사고의 경우 보험 업계와 연계하여 새로운 보험 사업 방향을 제시할 수도 있습니다.

무조건 차량 내부를 촬영해 탑승하는 승객들의 프라이버시를 침해하는 대신, 특정 소리 발생 시에만 차량 내부 카메라가 작동하게끔 하여 프라이버시 친화적인 보조 수단으로 승객의 안전성을 높일 수도 있고요.

4. 자율주행차 외부 인식

가령 주행 중인 도로에 큰 차 사고가 일어났다고 가정해 볼게요. 앞에 다른 차량들로 가려져 있다면 시각 정보에서는 차 사고가 났다는 사실을 파악하고 이를 주행 상태에 즉각적으로 반영하기 보다는, 그저 도로가 막히는 상황 정도로만 인식할 수 있습니다. 하지만 만약 차 사고 상황에서 발생하는 타이어가 급하게 멈추는 소리, 유리 파손 소리, 혹은 사이렌 소리 등의 청각 정보가 함께 반영된다면 자율주행차량은 주행 상황에 대해 더 자세하고 깊은 이해가 가능하며 이를 주행 시 반영할 수 있습니다.

현재 웨이모는 긴급 차량 접근 시 이를 감지하고 갓길에 정차하는 식으로 양보해, 안정적으로 상황에 대처할 수 있는 기능이 탑재되어 있습니다. 하지만 위에 언급한 것처럼 해당 긴급 차량이 ‘보이지 않는’ 상태라면 대응하기 어려울 수 있겠죠. 이때 사이렌 소리를 인지하는 것 뿐만 아니라, 소리의 방향성까지 추정 가능하다면, 자율주행량이 양보할 것인지, 회피할 것인지 등의 신속한 의사결정을 내릴 수 있습니다. 더 나아가 복잡한 교통 상황에서도 교통 규제나 도로 교통 법상 요구되는 최소한의 안전성을 충족할 수 있고요. 위와 같은 방식으로 자율주행차량이 사고를 예방하고, 회피할 수 있다면 자율주행차량에 대한 시민들의 사회적 신뢰 또한 제고될 수 있지 않을까요?

자율주행 기술은 날이 갈수록 변화하고 발전해 나가고 있습니다. 이제 다음 스텝으로 넘어가 일반 대중과의 신뢰 격차를 좁히기 위해 ‘보는 차’에서 ‘듣는 차’로 레이어를 추가할 차례입니다. AI가 점점 더 인간처럼 사고하기 위해 multi modal AI로 진화하는 것처럼, 자율주행도 새로운 변화의 기로에 서 있습니다.