Tech Scene을 선도하는 기업 중 하나인 Lenovo에서 개최한 Lenovo Tech Day’24, It’s All About Smarter AI 행사에 Cochl이 함께 발표하게 되었습니다. 행사명에서 알 수 있듯 이번 Lenovo TechDay는 ‘AI’를 주제로 다양한 이야기들이 펼쳐졌습니다. ‘AI for Sound: 머신 리스닝 기술로 만드는 더 안전한 스마트시티’를 주제로 Cochl의 사업 개발 매니저인 수영 님도 세션을 진행하셨는데요, 수영 님의 발표를 통해 빠르게 발전하고 있는 머신 리스닝 기술이 스마트시티의 어떤 부분에 적용 가능한지 또한 우리의 일상생활을 얼마나 효율적으로 더 안전하게 할 수 있는지 알아보겠습니다.

‘AI’라는 단어는 이제 우리 삶에서 떼어놓을 수 없을 만큼 가까워졌습니다. Generative AI, Large Language Model(LLM), Vision AI 등의 용어 또한 대다수 사람에게 이제 어색하지 않습니다만, ‘AI for Sound’는 어떨까요?

왠지 Sound와 AI라는 단어가 합쳐지니 우리의 스마트폰에서 쉽게 만날 수 있는 시리나 빅스비가 생각나시나요? 혹은 요즈음 유행하고 있는 유명 가수들의 목소리를 활용한 AI 커버? 넓게 본다면 말씀하신 모든 것들이 해당합니다. 저희 Cochl은 그중 머신 리스닝이라는 기술을 중점적으로 다루고 있습니다. 머신 리스닝이란 일상 속 도시 소음, 음악, 기계 소음부터 사람 목소리까지, 다양한 소리를 인식하고 분석하는 AI 분야로 신호처리와 머신러닝을 이용해 소리에서 유용한 정보를 얻어내는 기술입니다.

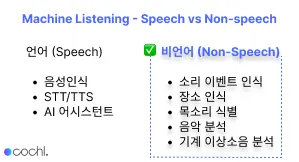

많은 분이 Sound AI하면 떠올릴 음성인식이나 AI 어시스턴트, STT (Speech-To-Text)나 TTS (Text-To-Speech)는 언어적 측면에서의 Sound AI를 일컫습니다. Cochl은 그보다는 비언어적인 표현들에 귀 기울이며 목소리를 식별하거나, 기계에서 감지되는 이상 소음을 분석하거나, 발생하는 소리 이벤트를 인식하는 쪽에 더 초점을 두고 있습니다.

‘비언어적인 소리에 유용한 정보가 있나요?’

사실 ‘비언어적인 소리’가 시각적으로 보이는 것이 아니기에, 어떻게 유용한 정보가 그 속에 들어있는지 상상하는 것은 쉽지 않습니다. 그래서 더 쉬운 이해를 돕기 위해 여러 예시를 들어볼게요.

가령 기존의 공장에서는 생산 라인마다 직원들을 배치해두고, 생산 설비 내에서 이상한 소리가 들리는지 확인했어야 했습니다. 하지만 이는 사람마다 다른 기준점을 갖고 있고, 획일화하기 어렵기에 사실 사람을 통해 이상 소음을 감지하는 것은 정확하지 못했습니다. 다만 Sound AI를 통해 이상 소음의 기준을 정량화하여, 불량품을 탐지해내는 방식으로 더 신뢰성 있는 검증 결과를 만들어 낼 수 있습니다.

혹은 맨눈으로 보기 힘든, 저 바닷속 깊은 생태계가 궁금하다면 어떻게 해야 할까요? 많은 국가나 연구기관에서 해저 생태계 연구목적으로 수중 마이크를 바닷속에 설치하여 해저에서 발생하는 소리를 녹음합니다. 이때 녹음된 소리를 분석하기 위해선 사람이 직접 들어봐야 하는 경우가 많은데, 24시간 내내 녹음된 데이터를 사람이 전부 분석하는 데는 어려움이 있습니다. 그런 어려움을 Sound AI가 특정 소리만을 탐소리의 특성에 따라 데이터를 분류하면서 해소할 수 있다면 어떨까요? 빙하의 움직임이나 해저 생물들의 활동을 소리로 확인하면서 해저에서 어떤 생태 활동이 일어나고 있는지, 특정 자연현상이 발생하는 징조를 더 빠르고 정확하게 파악할 수 있습니다.

좀 더 실생활에 가깝게 예시를 들어보겠습니다. 혼자 거동이 불편한 환자나 노인 분들의 경우 신체 능력이 일반인보다 떨어지기 때문에 사고의 위험성이 높습니다. 이동 중 넘어지거나 혹은 높은 곳에서 떨어지면서 발생하는 ‘쿵’ 소리를 누구보다 빠르게 감지할 수 있다면 설령 넘어지더라도 더 빠른 후속 조치가 가능하지 않을까요? ‘소리’를 통해 어르신 분들의 사고를 감지하고 원격으로 환자를 모니터링한다면 더 안전한 삶을 누리실 수 있을 것입니다.

이미 우리는 소리에서 많은 정보를 유추해 이를 바탕으로 상황을 해석하며 살아가고 있습니다. 단지 각각의 경우를 인지하지 못했을 뿐이죠.

원래 주제로 돌아가 ‘머신 리스닝 기술’이 어떻게 스마트시티를 더 안전하게 할 수 있을까요?

첫 번째로 도로 교통 관제에도 머신 리스닝 기술이 사용됩니다. 차를 직접 운전해보면 도로에 생각보다 CCTV가 많이 설치된 것을 느끼실 건데요, 과속 방지 카메라부터 교통관제용으로 설치된 CCTV들을 도시 곳곳에서 쉽게 찾아볼 수 있습니다. 다만 실시간으로 설치되어 있는 모든 CCTV를 두 눈 크게 뜨고 감시하고, 기록된 데이터를 분석하고 처리하기에는 인력 운용의 한계가 있는데 이 한계점을 머신 리스닝 기술이 보완해줄 수 있습니다.

Cochl의 Sound AI 기술은 다양한 형태로 제공되고 있는데, Cloud API를 통해 원하는 서비스나 소프트웨어에 직접 붙일 수도 있고 혹은 Edge SDK 형태로 제공해 별도의 인터넷 연결 없이 원하는 하드웨어에 탑재할 수도 있습니다.

여기서 주의 깊게 봐야 하는 부분이 바로 ‘Edge SDK’인데요, 이 말인즉, 따로 장비를 재설치할 필요 없이 기존에 깔린 CCTV에 충분히 Sound AI 기술을 활용할 수 있다는 점입니다.

이를 통해 인적이 많은 도로나 터널, 교량을 집중적으로 감시하며 자동차 사고를 더 촘촘하게 확인할 수 있고 교통량이 혼잡한 지역에서는 교통량 병목 현상의 빠른 원인 파악을, 소음 공해가 심한 지역에서는 소음 공해를 일으키는 차량을 감지하는 등의 방식으로 더 쾌적한 도시를 만들어 나갈 수 있습니다.

더 나아가 머신 리스닝 기술의 도입은 사고 발생을 모니터링하는 인력을 절감하고, 절감된 인력을 오히려 빠른 사고 대응에 활용하거나 더 큰 의사결정이 필요한 부분에 투입할 수 있습니다.

두 번째로 공공장소의 치안·방범에서도 머신 리스닝 기술이 활용될 수 있습니다. 정경석 외 3명에 따르면, 버스 터미널, 백화점, 역 등 인구 유동이 매우 빈번한 지역일수록 다양한 건물들이 위치한 지역적 특성 때문에 범죄다발지역으로 분류됩니다. (정경석 외. (2009) GIS와 공간통계기법을 이용한 시⋅공간적 도시 범죄 패턴 및 범죄 발생 영향요인 분석, <한국 지리 정보학회지>, 12(1), 12-25) 특히나 대형 쇼핑몰이나 경기장의 경우 실내 공간에 다수의 인구가 밀집됨에 따라 사건사고 발생 시 상대적으로 피해가 클 수밖에 없습니다. 이런 특성이 있는 공간일수록 CCTV나 인력만을 이용해 질서를 유지하는 것은 어렵습니다.

최근 유행하고 있는 무인점포에서도 인력이 상주하고 있지 않은 점을 노려 도난 사건이 증가하는 추세를 보이고 있습니다. 이런 상황에서 머신 리스닝 기술이 도움이 될 수 있습니다. 사건이 일어나는 상황에서 발생 가능성이 큰 비언어적 소리 - 유리 깨지는 소리나, 비명, 총소리, 폭발하는 소리 등을 Sound AI가 감지할 수 있다면 사건에 실시간으로 대응하여 더 큰 규모로 피해가 번지는 것을 빠르게 예방할 수 있습니다.

오늘은 간단한 사례를 통해 머신 리스닝 기술이 어떻게 우리가 살아가고 있는 도시를 변화시킬 수 있는지를 알아보았습니다. 기술 트렌드 리서치 업체 테크나비오에 따르면 전 세계 스마트시티 시장 규모는 오는 2027년까지 2,887억 달러로 성장할 것으로 전망되었습니다. 여러 유형의 데이터를 바탕으로 자산과 자원을 적절하게 배치, 효율적으로 관리하여 사람들의 삶의 질을 높이는 것이 스마트시티의 목적인 만큼 Sound AI의 활용은 스마트시티에 보다 한 걸음 더 가까이 갈 수 있는 유용한 도구가 되어줄 수 있습니다. Sound AI를 통해 더 안전하고, 지속 할 수 있는 우리의 삶을 함께 그려보아요!

.jpg&blockId=ea429f17-ae65-4305-bfc9-13e6754bebde)