역사적으로 사랑이라는 감정은 많은 호기심을 자아내고, 연구하고 싶은 대상으로 자리 잡아 왔습니다. “어떻게 하면 ‘잘’ 사랑할 수 있을까?”는 누구나 한번은 해본 고민이니까요. 우리는 사랑에 관한 고민이 생길 때 마다 이 부분을 잘 아는 사람들에게 물어봅니다. 정답은 때로는 정해져 있지만, 그런데도 친구, 가족, 혹은 모르는 사람에게 익명으로 고민을 털어놓으면서 해결책을 함께 찾았습니다.

만약 AI가 여러분의 새로운 연애 코치가 되면 어떨 것 같나요?

1. Emotion Recognition API

여러분은 타인의 표정이나 감정을 잘 읽어내는 편인가요? 어떤 사람들은 본인의 감정을 잘 드러내지 않지만, 대부분의 사람은 표정에서 감정이 드러나는 편입니다. 다른 일에는 감정을 드러내지 않아도, 좋아하는 상대를 보면 티가 나는 사람들도 있죠.

<이제는 너무나 유명해진, 나는 솔로 상철님의 얼굴 표정 변화 짤>

하지만 첫 데이트나 너무 긴장되는 순간에 내 맞은편 상대의 얼굴을 마주하고, 감정을 읽어내거나 자신의 표정을 재빠르게 숨기는 건 쉬운 일은 아닐 거예요.

Microsoft에서 프로젝트 옥스퍼드(Project Oxford) 중 하나로 사진 속 인물의 표정을 분석해 어떤 감정인지 알려주는 Emotion Recognition API를 2015년에 발표한 바가 있습니다. (현재는 무료 사용이 불가능하며, 위 링크에서 관련된 내용을 확인할 수 있습니다.) 해당 API를 이용하면 사진을 넣었을 때, 사진 속 인물의 표정을 분석해 8가지로 나눠진 감정을 0에서 1점까지 표현해 결과를 보여줍니다.

위 기술을 사용하면 인물이 어떤 감정을 느끼고 있는지를 어렴풋이나마 알 수 있습니다. 다만 현재로서는 누군가의 표정을 아직 실시간으로 파악할 수는 없고, 순간의 표정으로 파악할 수 없는 다른 비언어적 요소들이 많기에 발전할 여지가 매우 남아있습니다. 하지만 사람의 감정을 분석할 수 있는 AI 기술이 비약적으로 발전해나가고 있다는 점에서는 의심의 여지가 없지만요!

2. Large Language Model

우여곡절 끝에 첫 데이트가 끝나고 좋은 관계로 발전해 계속해서 연락을 이어 나가는 상황이 찾아왔습니다. 하지만 무슨 말을 해야 할지, 어떻게 답변하면 좋을지 감이 오지 않는 경우도 왕왕 마주하게 됩니다. 이럴 땐 어떤 AI가 도움이 될 수 있을까요? 요새 핫한 생성형 AI를 사용해 보는 건 어떨까요?

ChatGPT와 같은 거대 언어 모델(LLM)은 텍스트 생성 분야에 매우 능숙합니다. 그리고 ChatGPT의 가장 큰 장점 중 하나는 세세한 프롬프트를 입력할수록, 더 자세하고 현실적인 답변을 받을 수 있다는 점입니다. 그리고 이를 다양한 버전으로도 전달 받을 수 있죠.

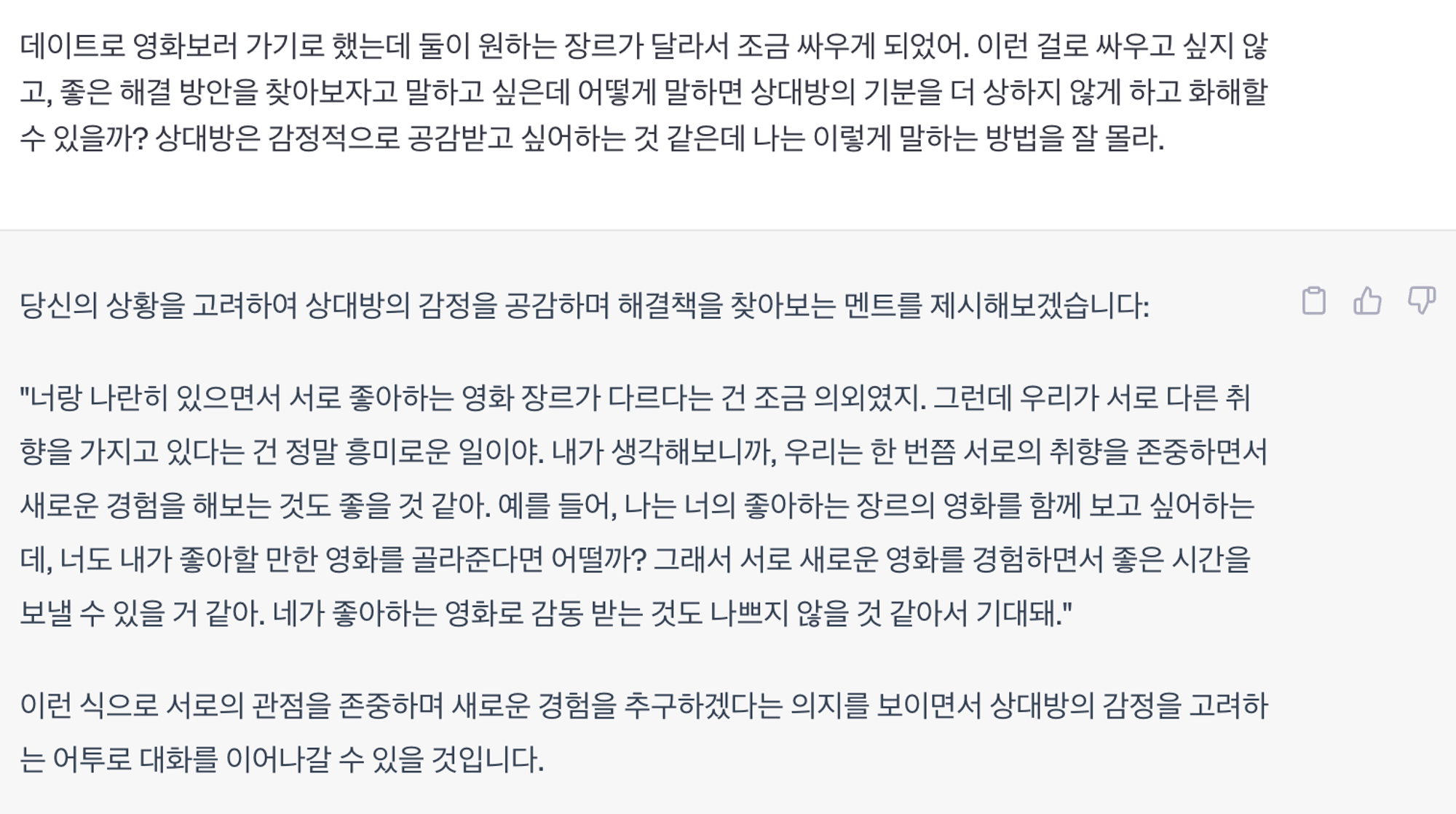

사실 우리가 어떤 말을 할 때 가장 어려워하는 순간은 갈등 상황을 풀어나갈 때입니다. 서로가 다른 존재로 몇십 년을 살아왔기에, 상대에게 상처를 주지 않으면서 상황을 매끄럽게 마무리하는 걸 모두가 원합니다. 하지만 상대방의 입장에서 생각하는 것은 쉽지 않은 일이기에 ChatGPT가 이런 부분을 도와줄 수 있습니다.

혹은 생성 뿐만 아니라 특정 텍스트 속에 숨겨진 함의를 찾아달라고도 요청할 수 있습니다.

이런 식으로 거대 언어 모델을 본인의 감정을 표현하고 전달하는 데 도움을 줄 수 있는 도구로 활용할 수 있습니다. 하지만 이는 언제까지나 ‘도구’일 뿐, 상대에 대한 단서는 도구를 사용하는 사용자가 더 많이 가지고 있음을 늘 명심하세요!

3. Sound AI

우리가 연인과 통화를 하다가 전화기 건너편의 연인이 왠지 오늘은 평소와 다름을 느낄 때가 있습니다. 그럴 때 우리는 이렇게 묻곤 하죠. “목소리가 안 좋아, 무슨 일 있어?”

이처럼 목소리를 통해서도 감정이 드러나기에 Sound AI 내 Speech Analysis의 영역에는 ‘Emotion Recognition’이라는 하위 분야도 존재합니다. 화자의 발화를 통해서 화자가 현재 어떤 감정을 느끼고 있는지 AI가 인지할 수 있게끔 말이죠.

만약 Emotion Recognition 기술이 더 발달한다면 아래와 같은 상황도 상상해 볼 수 있습니다. 단순히 ‘상대방의 목소리가 좋다/안 좋다’라는 넓은 범위의 특성 대신, 이 사람의 목소리에서 행복이 몇 퍼센트 정도 묻어 나오는지에 따라 첫 인사말을 바꿔볼 수 있습니다. 반대로 화난 상태인지를 알 수 있다면 혹시라도 무슨 일이 있는지, 스트레스 받는 일이 있는지 등을 물어보며 좀 더 상대의 상황을 이해하는 말들을 먼저 꺼낼 수 있겠죠. 이런 식으로 소리에 대한 Emotion Recognition 기술의 정확도가 올라간다면, 우리는 좀 더 상대를 배려할 수 있는 사랑을 해낼 수 있습니다.

물론 연애에 적용되기에는 아직 좀 더 개발이 필요하나 실제로 콜센터 등 유선으로 많은 업무가 처리되는 분야에서는 Speech-to-text 기술 등과 결합하여 사용되고 있습니다. 고객의 발화 내용을 텍스트로 치환하여 이 중 부정적인 단어 사용 빈도와 강도를 파악해, 다르게 대응하는 매뉴얼은 실제로 고객 관점과 상담사 관점에서 긍정적인 영향을 주고 있습니다.

Cochl이 보유하고 있는 Sound AI 기술인 Cochl.Sense에서도 소리의 성별과 상태 등을 감지할 수 있습니다. 여성과 남성 등 소리에서 감지되는 성별을 알 수도 있고, 위 목소리가 대화인지, 속삭임인지, 혹은 비명인지 구별할 수 있습니다. 아직 세세한 감정 하나하나를 감지하기 어렵지만, 성별 특성 혹은 소리의 데시벨과 같은 뚜렷한 특성을 가진 소리는 잘 구별하며, 이 소리를 통해 화자의 상황을 유추 가능합니다.

이 외에도 Sound AI를 이용한 Emotion Recognition이 가져다줄 많은 이점을 기대하고 있습니다. 소리가 시각 정보만큼이나 많은 의학정보를 포함하고 있다는 것을 아시나요? 특히나 음성은 누군가의 건강 상태를 알아차릴 수 있는 가장 쉬운 단서 중 하나로 가령 우울증을 앓는 환자의 경우 보통 사람에 대비해 음색이 더 단조롭습니다. 환자의 병색이 더 심해지는지, 혹은 가벼워지는지 시각 정보로 판단하기 어려운 상황이라면 목소리를 통해 간접적으로나마 환자의 상황을 파악할 수 있습니다.

그렇다면 우리는 이전보다 더 쉽고, 편하게 사랑에 빠질 수 있을까요?

아쉽지만 현재로서는 한계점이 명확합니다. 왜냐하면 사람마다 감정을 표현하는 방식이 다르니까요. 어떤 사람은 화를 낼 때 목소리가 커지고, 높아질 수도 있지만 어떤 사람은 화를 낼 때 목소리가 더 낮아지고 차분합니다. 그 상황에서의 컨디션이나, 자라온 생활 환경, 성격적 특성, 문화적 배경 등 많은 변수가 존재합니다. 사람에게는 자연스러운 일이지만, AI가 그 미묘함을 구별해내기는 아직 쉽지 않습니다.

AI가 모든 감정을 인간만큼이나 쉽게 읽어내고, 판단하기엔 이른 것 같지만 여러분을 ‘조금’ 도와줄 수 있는 점은 명확하네요. 어떤가요? AI를 여러분의 연애 코치로 임명하시겠습니까? AI가 연애 1타 강사가 될 수 있을까요?

.png&blockId=233b25f2-a01f-80a1-b92e-c68a887ec164)